On this blog I try to primarily write in English. However, in this case it makes more sense to write this lengthy post in Dutch, as it concerns a Dutch thesis (written in Dutch) that has caused a stir in the Netherlands.

In deze blogpost heb ik allerlei observaties en aantekeningen verzameld over een proefschrift over schrijven. Het leek me zonde om gewoon weg te gooien, hoewel er mensen zijn die mijn insteek onbenullig en schadelijk zullen vinden. Ik ga niet weken zwoegen op optimaal taalgebruik, trouwens. What you see is what you get. Misschien een van de auteurs van het proefschrift zelf, want tot nu toe heeft deze zelf ook twee blogposts over de media-aandacht geschreven. In een liet hij personen die de lage N aanvielen weten dat ze geen verstand van statistiek hadden, in een ander werden Galilei, Einstein en Hitler, alsmede de CV van een journalist er bij gehaald om aan te tonen dat het commentaar nergens op sloeg. DEZE BLOGPOST gaat daar niet over, die gaat over het proefschrift, over het proces schreef ik een ANDERE BLOGPOST.

In deze blogpost heb ik allerlei observaties en aantekeningen verzameld over een proefschrift over schrijven. Het leek me zonde om gewoon weg te gooien, hoewel er mensen zijn die mijn insteek onbenullig en schadelijk zullen vinden. Ik ga niet weken zwoegen op optimaal taalgebruik, trouwens. What you see is what you get. Misschien een van de auteurs van het proefschrift zelf, want tot nu toe heeft deze zelf ook twee blogposts over de media-aandacht geschreven. In een liet hij personen die de lage N aanvielen weten dat ze geen verstand van statistiek hadden, in een ander werden Galilei, Einstein en Hitler, alsmede de CV van een journalist er bij gehaald om aan te tonen dat het commentaar nergens op sloeg. DEZE BLOGPOST gaat daar niet over, die gaat over het proefschrift, over het proces schreef ik een ANDERE BLOGPOST.

Het proefschrift is hier te vinden. Het persbericht van 28 april 2014 hier.

Laat ik eerst beginnen, dat wordt straks toch vergeten, mijn waardering uit te spreken voor alle uitgebreide reacties van @mikvanes. Er is veel in de strekking van de reacties (allerlei locaties, twitter, BON forum) die mij aanspreekt: kennis verkrijgen is hard werken, en inderdaad moet het effectief zijn. Ik vind de gebalanceerde benadering van ICT inzet (met feedback) sterk; ik zie daar ook de voordelen van. Tevens zijn de hoofdstukken over beoordelaars e.d. interessant. Ook geloof ik dat de empirische benadering van de vraagstelling te prefereren over een theoretische: het proefschrift analyseert een probleem en probeert met een interventie een oplossing aan te dragen. Wat in de empirie echter ook van belang is, is dat je kijkt naar een nul-hypothese, en dat je vervolgens kijkt of er genoeg aanwijzing is dat je de nul-hypothese verwerpt. Sterker nog, dat is de kern van het verhaal.

Ik maak voornamelijk gebruik van de tekst in het proefschrift. Daar waar een van de auteurs ergens reageerde of toelichting gaf (en ik weet er van) dan zal ik dat meenemen. Waarbij ik wel eigenlijk vind dat het dan in het proefschrift had moeten staan. Wat opvalt in het persbericht, veelal de eerste kennismaking van de buitenwereld met een stuk schrijven, zijn twee zaken -waarvan later gezegd lijkt te worden dat de buitenwacht daar zich te veel op richtte. (i) Het is slecht gesteld met de schrijfvaardigheid van eerstejaars hbostudenten en universitaire docenten, (ii) Er is een softwareprogramma die schrijfvaardigheid verbetert. Er is door sommigen geopperd dat je ook niet op persberichten af moet gaan; het gaat immers om de inhoud, het proefschrift. Daarin staan echter even stellige uitspraken. Neem pagina 113:

Hier begint het: als ik dit lees verwacht ik dat een voor de ‘Nederlandse eerstejaars-studenten- representatieve steekproef is genomen. Bij het vermelden van het effect wordt gewag gemaakt van het feit dat er een klassieke controle/experimentele groep design is gebruikt. Daar zal ik dan kijken naar de details van die opzet. Dit betreft met name hoofdstuk 4 en 6. Ook de andere hoofdstukken heb ik echter gelezen en daar zeg ik ook nog wat over.

Representativiteit van de steekproef

De auteur was niet in mild in zijn blogpost met de bewering dat de criticasters van het onderzoek geen kaas van statistiek hadden gegeten. Uiteraard ben ik het eens met de opmerking dat representativiteit en steekproefgrootte twee deels gescheiden zaken zijn. Jij zegt “Bij steekproeven zijn twee zaken belangrijk in deze volgorde: 1. hoe ze geselecteerd zijn, 2. hoe groot ze zijn.”. Eens. Ze zijn echter wel gerelateerd.

Laten ik beginnen met de representativiteit van de steekproef in hoofdstuk 4.

- De steekproef is NIET aselect maar stratified random: er zijn groepen werkjes gekozen en binnen die groepen werkjes zijn aselect werkjes getrokken. Binnen de strata is gekozen voor diverse soorten schrijfwerk. Het type documenten dat gekozen is: hbo-light-in-werkcollege (ik noem deze groep 1), hbo-light-thuis (groep 2), hbo-project-intro (groep 3) en universiteit-taalbeheersing (groep 4).

- De steekproef is random binnen de strata, maar de keuze voor respectievelijk 5,5,10 en 10 is dat niet. Dit valt te zien als je kans berekent bij volledig random 30 op 159 documenten, en de verschillende strata:

-

| |

pop |

steekproef |

kans |

| Groep 2 |

31 |

5 |

0.16 |

| Groep 3 |

56 |

10 |

0.18 |

| Groep 1 |

40 |

5 |

0.13 |

| Groep 4 |

32 |

10 |

0.31 |

| Totaal |

159 |

30 |

0.19 |

De proportie universitaire teksten in hoger dan random, hbo lager. Nou zou dit zelfs kunnen betekenen dat er nog sterkere aanwijzingen zijn dat hbo studenten slechter schrijven dan universitaire studenten, immers de hoge proportie uni studenten ‘dempt’ die van de hbo studenten. Daarom had ik het beter begrepen als vermeld was dat het niet aselect was. Daarbij is dan geen rekening gehouden met het feit dat uit de beschrijving van de random steekproef af leiden valt dat sommige studenten in zowel groep 3 of (groep 1/groep 2) kunnen zitten(?).

- Ook statistisch gezien is het van belang dat rekening wordt gehouden met strata omdat stratified random sampling nogal eens leidt tot het onderschatten van de standaardfout

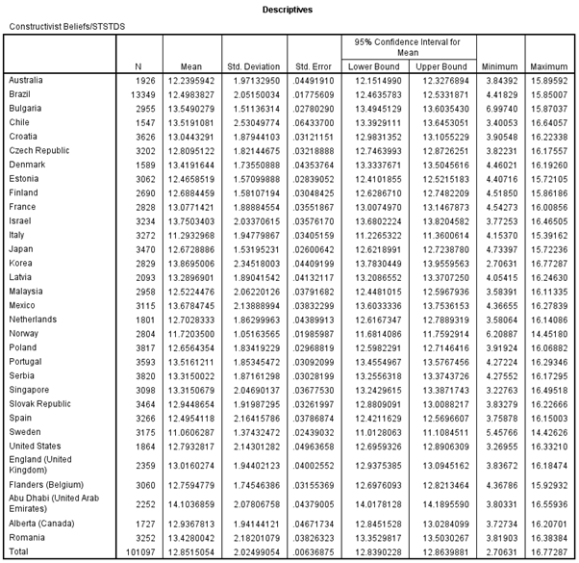

- Op p. 113 zeggen de auteurs, zoals in de tweet ook vermeld, dat “Het tweede belangrijke resultaat van het foutenonderzoek is dat Nederlandse eerstejaarsstudenten zeer grote aantallen bevestigde fouten PHW in hun Nederlandstalige schrijfproducten blijken te produceren.”. De auteurs doen uitspraken over ‘Nederlandse eerstejaarsstudenten’ en besteden bijna geen aandacht aan het feit hoe die 30 schrijfwerkjes representatief zijn voor die groep. Later lijkt de argumentatie bijna te zijn dat dit niet nodig is want (i) random, (ii) geen aanwijzing dat het bij andere opleidingen, steden enz. anders ligt. Dat laatste moet naar mijn mening onderbouwd worden.

- Overigens neem ik ook aan dat de opleiding CIW flink gegroeid is sinds 2007-2008 omdat 32 studenten voor de hele populatie niet veel is. In de studiekeuzemonitor zie ik nu ca. 140 studenten? Was de opleiding net nieuw? Of was die groter maar zijn dit representatieve groepen? Mijn lijn moge duidelijk zijn: ik verwacht meer informatie over dat ene punt representativiteit. Of preciezere formulering. Hier staat nu “Onze ‘steekproef’ zou dus representatief moeten zijn voor in ieder geval die 159 studenten.”, gezien de strata (zie hierboven) is dat de vraag maar het is in ieder geval heel wat preciezer naar mijn mening dan “Deze uitkomsten bevestigen eerdere berichten over de tekortschietende schrijfvaardigheid van eerstejaarsstudenten.” (p.112). en de eerder geciteerde zin op p. 113. Kortom, die precieze formulering had naar mijn mening consequent moeten zijn gebruikt.

- Binnen de groepen (strata) is ook nog eens sprake van een verscheidenheid aan schrijfomstandigheden: sommige mogen thuis worden gemaakt, andere niet. Ook is de ‘aard’ van de teksten verschillend. Of dat uitmaakt weet ik niet maar een korte analyse had niet misstaan. Bijvoorbeeld ten aanzien van de lengte van de teksten. Als op p. 104 wordt gemeld dat een kortere tekst meer fouten per honderd woorden lijkt te bevatten, dan moet je naar mijn mening uitsluiten dat de teksttypen die hbo en uni studenten schreven ongelijk waren.Een voorbeeld. Stel hbo studenten schreven gemiddeld 200 woorden met 60 fouten. Universitaire studenten 400 woorden met 80 fouten. De auteurs stellen terecht dat het natuurlijk niet ‘eerlijk’ zou zijn om te zeggen dat universitaire studenten slechter schrijven (80 fouten versus 60) omdat ze namelijk ook meer schrijven. Vandaar dat de auteurs zeggen: we gebruiken fouten per honderd woorden. Dat wordt dan respectievelijk 30 PHW versus 20 PHW, de hbo studenten doen het nu slechter dan de universitaire studenten. Maar ook met die conclusie moet je oppassen, immers de hbo studenten schreven gemiddeld veel korter en zullen dus niet alleen minder fouten in absolute zin hebben gemaakt, maar waarschijnlijk meer per honderd woorden. Om goed te vergelijken moet je naar mijn mening qua tekstlengte vergelijkbare groepen hebben. Dit wordt verder niet toegelicht.

Zeggen dat het logisch is dat hbo studenten korter schrijven omdat ze slechter in schrijven zijn is volgens mij een cirkelredenering. Dat wist je namelijk niet op moment van het nemen van de steekproef. De twee te vergelijken groepen moeten vergelijkbaar zijn, en hoewel ik het eens ben met de constatering dat er (te) veel fouten ten opzichte van, zeg een baseline van 10 fouten (of zeg 0), gemaakt worden, wordt er ook een vergelijking hbo versus uni gemaakt.

- De aanname dat de opleidingen CIW (Communicatie- en Informatiewetenschappen) en IBL (International Business and Languages) wel talig zullen zijn omdat ze over talen gaan, vind ik ook niet zo overtuigend. Is de redenering dat als zij al veel fouten maken, anderen dat ook wel zullen doen. De generalisatie naar andere opleidingen is niet sterk. Zo kan CIW gekozen worden met alle profielen, IBL ook vermoed ik, los van het HBO/WO verschil. Een passage over de representativiteit van deze opleidingen voor ‘eerstejaars’ was wel degelijk terecht geweest. Ik ben het dus niet eens met “Maar of dat allemaal echt waarschijnlijk is…” in de statistiek blogpost. Al had het maar zijn beschreven en daarna gezegd “Dus nemen wij aan dat…”. Maar het staat er volgens mij niet.

Mijn deelconclusie: de auteur(s) hebben niet goed duidelijk gemaakt dat de steekproef representatief genoeg is. Sommige uitspraken in het proefschrift kunnen naar mijn mening niet gedaan worden.

Grootte van de steekproef en vergelijken groepen

Dan de steekproefgrootte. Het klopt dat als een steekproef representatief is je met lagere N kunt volstaan dan sommigen denken. Nou vind ik de stelling dat de steekproef representatief is, vanwege voornoemde redenen niet zo overtuigend. Echter ook de stelling dat “De grootte van de steekproef is niet zo belangrijk, omdat we die via de standaardfout kunnen vertalen in een betrouwbaarheidsinterval.” (blog, laatste zin). Inderdaad, het is juist die standaardfout die de onzekerheid in de bevindingen weergeeft, en daarmee niet uitgaat van een absolute waarheid. Ik mis alleen een beschouwing van die onzekerheid. Zoals gezegd is het volgens mij zo dat de ‘stratified’ aanpak met verschillende kansen in de strata de standaardfout beinvloedt. Bij lage N moet je ook nog eens oppassen met biased/unbiased estimators van de standaardfout. Het is dus wel degelijk zo dat, zoals ook in de blog staat “Een heel grote, aselect getrokken steekproef is natuurlijk betrouwbaarder dan een kleine steekproef.”. Volgens is dat ook wat steeds betoogd is, samen met het bevragen van de representativiteit. Op twitter ging de discussie wat verder, bijvoorbeeld dat zelfs met N=2 een representatieve sample *kan* worden verkregen. Nou *kan* dat inderdaad maar aangezien je niets weet over de distributie van de populatie zal een dergelijk kleine sample een hoge mate van onzekerheid bevatten. Niet alleen zal de N-1 versie van de SD de SD van de populatie (en SE) licht onderschatten, bij gebruik van de t-test kunnen SD en SE volgens mij onderschat worden. Ook al omdat de standaardfout naar sd/wortel(N) nadert voor N voldoende groot.

Op p. 108 worden hbo en uni groep vergeleken. De eerste constatering is dat er PHW wordt gebruikt. Lijkt me prima. De sprong naar 1 A4 vind ik wederom onnodig. Het geeft een vertekend beeld van steekproef die weinig teksten van 500 woorden bevat (immers, gemiddelde veel lager). Dan de t-test. Ik mis degrees of freedom en t-waarde (plus effect size wordt meestal gemeld). Ik ga er maar van uit dat de groepen ongeveer normaal verdeeld zijn. Als N>30 dan hoeft dat niet (al blijf ik het testen) vanwege neigen naar normaal maar hier leek me dat wel logisch. Levene wordt niet meteen genoemd maar verderop. Ik ken die ook als controle of aanname ‘Homogeneity of Variance’ voor de t-test klopt. Aangezien p<.004 wordt de nul-hypothese dat ze gelijk zijn verworpen. De t-test is vrij robuust, maar ook dit wordt niet verder toegelicht. Nou is p<.001 vrij sterk maar ook hier weer: ik mis info. Met een non-parametrische test had je wellicht het zelfde resultaat gekregen.

Per honderd woorden of per A4

Ook niet helemaal precies is het omrekenen naar fouten per A4. Als de opdracht is om 500 woorden te schrijven, is het simpelweg opvallend als de range 135 tot 565 is met gemiddelde 279 en een sd van 104 woorden. Dat roept nog meer de vraag op of er (i) verschil was binnen de vergeleken groepen, zie punt 7 bij de steekproef, (ii) het handig is om naar 1 A4 om te rekenen, ook als daar ‘wat beter valt bij voor te stellen’ (in een tweet geantwoord).

Het beoordelen van fouten

Het berekenen van de fouten geschiedde zo ik begrepen heb op basis van ‘twee beoordelaars waren het eens’, zg. ‘bevestigde fouten’. Hoe je met die definitie op p.100 opeens kunt spreken over ‘kloppende en niet-kloppende fouten’ lijkt me raar. Wie bepaalt dat ze kloppen als de definitie zegt ‘twee zijn het eens’? Maar goed, die passage is netjes en interessant en concludeert aan het einde dat –ongeacht het feit dat er een mate van overeenstemming is- vooral het AANTAL FOUTEN PER HONDERD WOORDEN (PHW) sterk gecorreleerd is.

Wel knaagt ‘bevestigde fouten’ een beetje. Het is een originele insteek, maar gebruik makend van interbeoordelaars aspect heb je vanwege je definitie altijd te maken met 100% overeenkomst. Immers, 2 of meer moeten een fout bevestigen. Op pagina 101 staat een illustratieve lijst. Als ik het goed begrijp is beoordelaar 4 (b4) volgens het traditionele interbeoordelaars criterium het meest betrouwbaar. Immers, de auteurs hebben een criterium dat maakt dat een fout ‘bevestigd’ wordt en 87% van de door b4 gesignaleerde fouten wordt uiteindelijk ook bevestigd. Echter, die fouten zijn maar 46% van alle bevestigde fouten. Is dit geen cirkelredenering? Immers, de fouten van een beoordelaar maken deel uit van de definitie van een fout en vervolgens wordt de betrouwbaarheid uitgedrukt in een correlatie tussen alle fouten van een beoordelaar en wat uiteindelijk overblijft als bevestigde fout. 3980 fouten, 2400 verschillende. 1411 van maar 1 beoordelaar, 989 bevestigd door een andere beoordelaar. Op pagina 99 wordt ook gemeld dat tweederde van de fouten van een beoordelaar gemiddeld bevestigd werden. Maar dat hangt toch sterk af van het aantal beoordelaars? Immers, als je meer beoordelaars hebt, is de kans groter, bij 2/3 individueel bevestigend, dat er wel een beoordelaar tussen zit die een fout bevestigt.

Uit de tabel op p. 106 en de bijlage op http://dl.dropboxusercontent.com/u/6861883/Bijlagen%203%2C%205%20en%206.pdf met soorten fouten blijkt overigens ook dat het type fouten een in mijn ogen soms gekke mix van taal- en stijlfouten bevat. Wat is ‘verkeerd woord’? Wanneer is een woord verkeerd? Wanneer loopt een zin niet? Wat is een alinea indeling? Wat is een overbodige zin? Nou snap ik op zich wel dat een moedig poging wordt gedaan om een subjectieve waardering –ik bedoel dus niet een echte spelfout maar een stijlfout- objectiever te maken door het criteria “bevestigde fouten” te hanteren De discussie erover lijkt me gerechtvaardigd. Vervolgens wordt ook gezegd dat er verschillend over fouten werd nagedacht (daarmee wordt eigenlijk de noviteit van de methode weer teniet gedaan) maar dat het aantal fouten per honderd woorden. (PHW). Kortom, een originele aanpak maar niet zonder uitdagingen.

Falend onderwijs versus TAVAN

In het proefschrift staan ook stellige uitspraken over hoe het schrijfonderwijs gefaald heeft (zie de eerste tweet bijvoorbeeld). Ik kan het eens zijn met de conclusie zoals die buiten het proefschrift geformuleerd is: “eerstejaars studenten leren in het voorafgaande onderwijs niet foutloos te schrijven. We zeggen niet dat het vroeger beter was. We kunnen alleen constateren dat foutloos schrijven nu in ieder geval niet in het voorafgaande onderwijs geleerd wordt.”. Maar dat klopt alleen als 0 fouten(foutloos) alleen als effectief gezien wordt. Daar kan ik wel in meegaan: 0 fouten is perfect en je kunt er niets meer aan verbeteren (maar: zie de passage over fouten). Ik vind het alleen wel een onhaalbare eis: als 0 fout ‘effectief’ is dan kun je niet zeggen dat 20% minder fouten voor je eigen interventie effectief is voor het een en dan andere neerzetten als ‘falend’ omdat de 0 fout niet gehaald wordt. Effectiviteit meet je door te vergelijken hoe het was (pre) en hoe het werd (post) en die uitspraken kun je NIET doen over andere/huidige methoden. Een doelstelling van 0 fouten haalt TAVAN helaas ook niet. De tekst van het proefschrift is naar mijn mening minder zorgvuldig met zinnen als “Kennelijk is het voorafgaande onderwijs op dit punt niet effectief geweest” (p. 113). Volgens de ‘0 fouten benchmark’ is TAVAN dat ook niet, toch wordt daar het standpunt gehuldigd dat het effectief is. Ik vind dat daar de goal posts verplaatst worden tussen hoofdstuk 4 en hoofdstuk 6: of je zegt “we weten niet hoe het voorgaande onderwijs was dus lastig te zeggen of het effectief was of niet”, of je zegt “0 is de benchmark (of zelfs 10 maar dat is al meer arbitrair want is dat per A4, per honderd woorden)” en houdt ook TAVAN er aan. Ik denk dat wat me stoort hier weer die nadruk is de “het huidige onderwijs is slecht, kijk maar” claim, die toch wel onder het hele proefschrift ligt. Die vergelijking is simpelweg niet te maken. Minder fouten door TAVAN kan ik best zien als voordeel, en dat wordt in hoofdstuk 6 uiteengezet (helaas weer, om dezelfde redenen als hiervoor, met erg lage N). Het wordt echter vergeleken met het ‘normale onderwijs’ in de voornoemde opleidingen. Ook kreeg de controlegroep 11 uur minder schrijfondersteuning. Daarnaast is het de ‘oude manier zoals die binnen die opleidingen werd gehanteerd’. Veralgemeniseren tot falend schrijfonderwijs kan daarom niet, op basis van deze gegevens.

Het experiment met TAVAN

Ik vond het resultaat van de experimentele groep TAVAN eerlijk gezegd wat tegenvallen: 20 uur om van 19 fouten PHW naar 15 vond ik niet zo erg veel, ook al was het een sterk effect. Daarbij is er ook nog sprake van een controlegroep TAVA die maar liefst 11 uur minder onderwijs kreeg en werd onderwezen door andere personen. De weekverdeling (3 keer 3 met spreiding of aaneengesloten, versus de 10 keer 2) wordt ook niet beschreven. De keuze voor ‘verbeterteksten’ vond ik opvallend, zeker gezien de argumentatie “Verder zouden bij een volledige open opdracht ook onnodig inhoudelijke verschillen ontstaan tussen de teksten die zouden kunnen doorwerken in de beoordeling op aantal fouten PHW.” (p. 194). Immers, dat was toch ook zo in het foutenonderzoek? Weten we zeker dat fouten verbeteren hetzelfde is als foutloos schrijven? De analyse van dropout had wel wat uitgebreider gekund als maar 38 studenten van de 60 beoogde overblijven.

De tool TAVAN

Een echte indruk van de tool krijg ik niet, dus kan alleen afgaan op de beschrijvingen. Ik vrees dat in veel ELO’s en particuliere sites iets soortgelijks, dan bedoel ik vragen die precies moeten matchen en dan bescheiden feedback, al zeer veel voorkomt. De originele slag is om het aan te wenden voor schrijfonderwijs. Daarom vrees ik dat het met dat idee erg makkelijk zal zijn om iets soortgelijks te maken, ook voor goedbedoelende amateurs. Sterker nog, uit eigen ervaring weet ik dat dit al volop gebeurt op VO scholen.

Overige hoofdstukken

De literatuur in hoofdstuk 2 is naar mijn mening onevenwichtig met 20 pagina’s die laten zien dat het schrijfonderwijs ondergewaardeerd werd en 3 pagina’s positief onderzoek erover. Of eigenlijk anders: dat het onderzoek naar het schrijfonderwijs niet op evidentie is gebaseerd (zie bijv. p. 33). In mijn beleving doen de auteurs daarmee eigenlijk wat ik doe in deze blog: onderzoek methodologisch bekritiseren(al lijkt er soms een ondertoon in te zetten dat de desbetreffende onderzoekers in het verleden ook wilden dat schrijven er slecht van af zou komen). Het gevolg is weliswaar interessant leesmateriaal, maar ik vind het opvallend dat dergelijke kritiek op eigen werk vervolgens met vitriool beantwoord wordt. Ik denk dat het proefschrift aan kracht zou hebben gewonnen als dit hoofdstuk evenwichtiger was.

Wat me opviel in hoofdstuk 5 is dat er bij de beoordeling van de methodes, behoudens het opnieuw bekijken van 2 methodes door de medeauteur, geen gebruik wordt gemaakt van een onafhankelijke tweede beoordelaar. Ook valt het op dat de beoordeling gebruik maakt van de typen fouten; iets waar de auteurs zelf over zeiden dat er moeilijk conclusies over getrokken konden worden.

Hoofdstuk 7 koppelt de holistische beoordeling aan PHW voor zowel expert- als studentbeoordelaars. Een interessant hoofdstuk. Ook hoofdstuk 8 heeft een mooie reeks literatuur plus overzicht van meetmanieren voor schrijven en bevestigt nogmaals dat fouten PHW in een tekst correleert met de TAVAN score en de holistische beoordeling. Ook interessant, al zou ik wel voorzichtig zijn met causale conclusies, maar ook of ze daarmee even betrouwbaar zijn. Ook hoofdstuk 9, over betrouwbaarheid is interessant; vaak een onderwerp dat niet genoeg beschouwd wordt.

Samengevat

Dit onderzoek heeft veel losgemaakt en dat is knap. Het is goed dat er stevig onderzoek wordt gedaan naar iets wat beschouwd wordt als een belangrijke vaardigheid: het schrijven. In dat opzicht is het proefschrift een aanwinst. Ik vind met name de tweede helft vrij sterk. De eerste helft vind ik echter erg onnauwkeurig formuleren. Van de kritiek die ik las ging het meeste over de harde conclusies op basis van de steekproef. Ik post nogmaals:

Welnu, (i) zowel proefschrift als persbericht generaliseren met een stevige uitspraak, (ii) op basis van de steekproef (en grootte ervan) is er maar beperkte evidentie dat ‘Nederlandse eerstejaars studenten’ slecht zijn in schrijven, (iii) of het schrijfonderwijs faalt kan daarmee ook niet gezegd worden, behalve als men stelt ‘het moet 0 fout zijn’, (iv) de tool TAVAN vermindert het aantal fouten van 19 naar 15 per honderd woorden maar hoe veel beter dan ‘de oude situatie’ is lastig te zeggen omdat het gaat om een specifiek ander programma dat 11 uur minder schrijfonderwijs geniet.

Let wel, ik zeg NIET dat het schrijven van studenten misschien wel niet zo slecht *is*. Misschien wel. Ik verbaas me, op basis van mijn eigen ervaring, over gebrekkige schrijfvaardigheid van vele mensen. Het gaat simpelweg over het proefschrift dat hier voor ligt. Alle begrip dat je bij sociale wetenschap niet met alles rekening kunt houden; je kunt niet in alle steden voor alle opleidingen al het schrijfwerk beoordelen (alleen al: welke opdracht hebben ze allemaal gekregen?). Je maakt keuzes. Die keuzes rechtvaardig je. Tenslotte formuleer je conclusies en uitspraken die passen bij die evidentie. Daarbij hoef je jezelf niet weg te cijferen, maar simpelweg stellen ‘ze schrijven slecht en door TAVAN wordt het beter’ is naar mijn mening wel erg kort door de bocht. DAT was de aanleiding voor mijn reactie(s), niet meer en niet minder.